涉及知识点:集成学习算法 (Ensemble Learning)

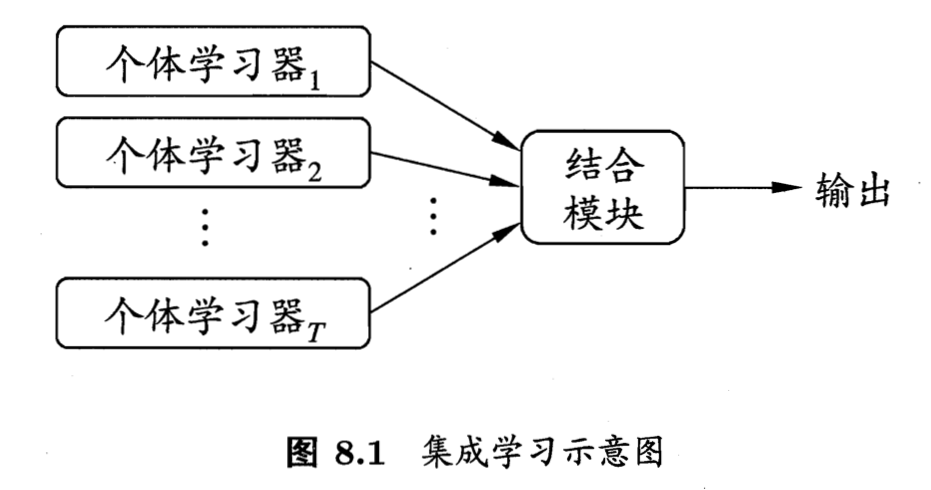

传统机器学习算法 (例如:决策树,人工神经网络,支持向量机,朴素贝叶斯等) 的目标都是寻找一个最优分类器尽可能的将训练数据分开。集成学习 (Ensemble Learning) 算法的基本思想就是将多个分类器组合,从而实现一个预测效果更好的集成分类器。

Thomas G. Dietterich指出了集成算法在统计,计算和表示上的有效原因:

- 统计上的原因

一个学习算法可以理解为在一个假设空间H中寻找到一个最好的假设。但是,当训练样本的数据量小到不够用来精确的学习到目标假设时,学习算法可以找到很多满足训练样本的分类器。所以,学习算法选择任何一个分类器都会面临一定错误分类的风险,因此将多个假设集成起来可以降低选择错误分类器的风险。 - 计算上的原因

很多学习算法在进行最优化搜索时很有可能陷入局部最优的错误中,因此对于学习算法而言很难得到一个全局最优的假设。事实上人工神经网络和决策树已经被证实为是一个NP 问题[3/4] 。集成算法可以从多个起始点进行局部搜索,从而分散陷入局部最优的风险。 - 表示上的原因

在多数应用场景中,假设空间H中的任意一个假设都无法表示(或近似表示)真正的分类函数f。因此,对于不同的假设条件,通过加权的形式可以扩大假设空间,从而学习算法可以在一个无法表示或近似表示真正分类函数f的假设空间中找到一个逼近函数f的近似值。

集成算法大致可以分为:Bagging,Boosting和 Stacking等类型。

原文链接:

https://leovan.me/cn/2018/12/ensemble-learning/

评论 (0)